深圳新闻网2025年11月5日讯(记者 刘惠敏)你是否曾遇到过这些情况:用文字指令来编辑图片时,AI似乎无法完全理解你的意思。比如,想给照片里的猫戴上一顶帽子,AI生成的结果中帽子可能位置不对或者风格怪异;想把照片中的“红色轿车”换成“蓝色”,AI却可能把画面里所有的红色物体都改了个遍。

现在,一项来自中国团队的技术突破,正在让图像编辑变得前所未有的简单和精准。

日前,深圳兔展智能科技有限公司与北京大学的UniWorld团队联合发布新一代图像编辑模型UniWorld-V2,首次将强化学习(RL)策略优化应用于统一架构的图像编辑模型,是第一个视觉强化学习框架。UniWorld-V2在权威测试中取得了SOTA成绩(State of the Art,在特定领域或任务中性能保持领先水平),在综合表现上超越了如OpenAI的GPT-Image-1等顶尖闭源模型。

从“大概听懂”到“精确理解”

过去AI模型的普遍痛点在于,对图片内容的理解不够细致、精准。

UniWorld-V2模型的强大之处,就在于它极大地解决了这个“精准理解”的难题。它不仅能听懂用户的文字指令,更能像人一样,精准地“看懂”图片中的每一个细节和对象。无论是让你圈出图中的某个部分,还是直接口头描述你想修改的地方,UniWorld-V2都能准确锁定目标,实现“指哪打哪”的精确编辑。

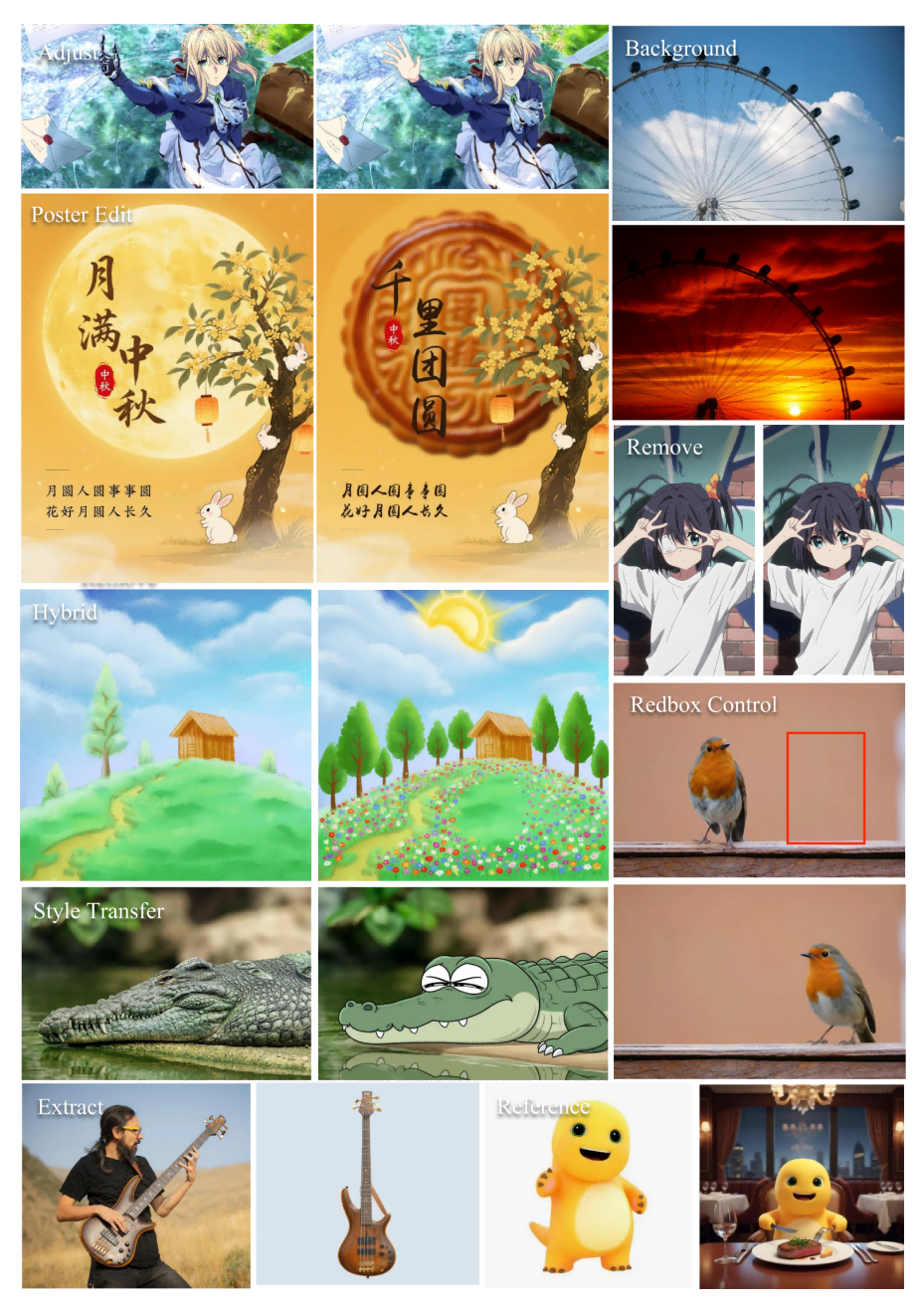

在兔展智能与北京大学的UniWorld团队联合发布的论文中,不少示例展现了强大的中文字体掌握与精细化可控能力。例如,当用户提出“把中间白色衣服戴口罩女生的手势改成OK”时,UniWorld-V2可以准确完成修改,而同类模型Nano Banana则未能理解指令意图。

“海报编辑”示例中,模型能精准理解指令,并渲染出“月满中秋”和“月圆人圆事事圆”等笔画复杂的艺术中文字体,效果清晰、语义准确。

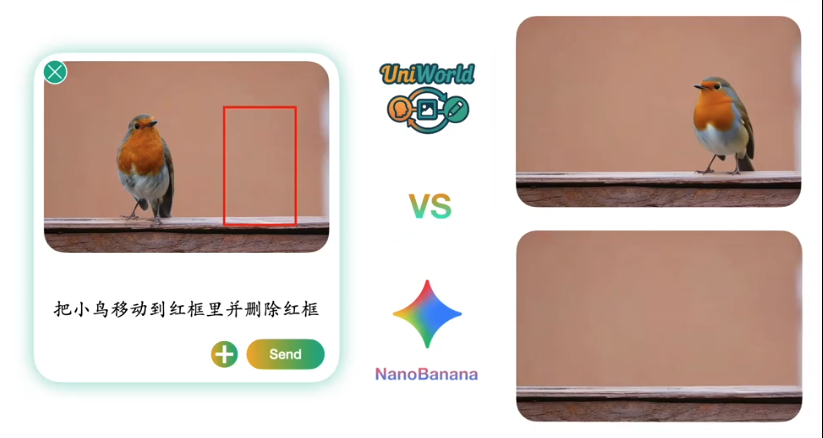

在“红框控制”任务中,用户可以通过画框(如红色矩形框)来指定编辑区域,模型能够严格遵守该空间限制,实现“将鸟移出红框”等高难度精细操作。

此外,模型能深刻理解“给场景重新打光”等指令,使物体自然融入场景之中,让画面变得更统一和谐,并且光影融合度极高。

核心驱动力:全球首个视觉强化学习框架UniWorld-R1

实现以上功能,研究团队的核心创新在于提出了UniWorld-R1框架。

传统的图像编辑模型依赖监督微调(SFT),普遍存在对训练数据过拟合、泛化能力差的问题。此外,还存在面对编辑指令和任务的多样性,缺乏通用奖励模型的瓶颈。

UniWorld-R1框架的创新设计首次将强化学习策略优化应用于图像编辑领域,并创新性地使用多模态大语言模型作为奖励模型,显著提升了模型与人类意图的对齐能力。

在GEdit-Bench和ImgEdit等权威测试中,UniWorld-V2分别获得7.83和4.49的高分,超越了所有参与对比的开源和闭源模型。值得注意的是,UniWorld-R1框架同样适用于其他基础模型,能有效提升其编辑性能。

目前,该研究的论文、代码和模型已在GitHub和Hugging Face平台开源,为后续研究提供了重要基础。

有分析指出,这项技术的突破,将极大降低专业图像编辑的门槛,推动图像编辑技术走向更智能、更可控、更实用的新阶段,并催生全新的应用场景。

(本文图片来自相关论文及受访单位)